Analytics Daten Architectur

Use Case

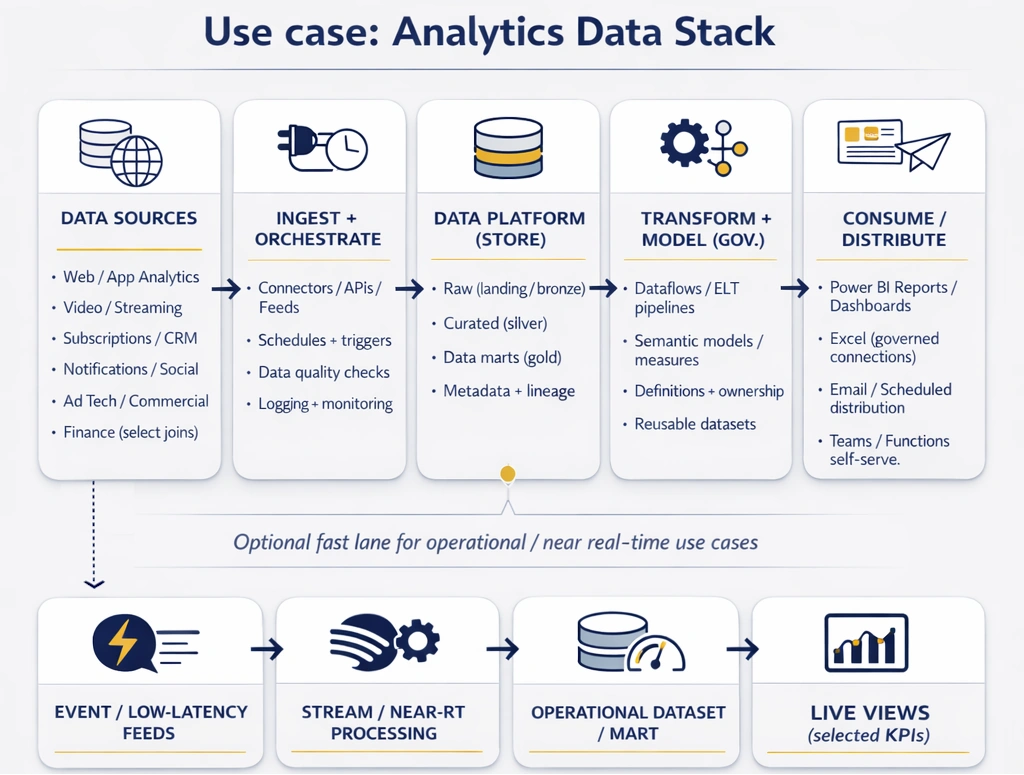

Medienorganisationen waren auf manuelles Reporting angewiesen: Analysten erstellten Excel- und PowerPoint-Pakete, versendeten sie per E-Mail und wiederholten denselben Aufwand in jedem Reporting-Zyklus. Daten lagen fragmentiert über digitale und kommerzielle Plattformen verteilt (Web-Analytics, Video, Abonnements, Benachrichtigungen, Social, Ad Tech) und wurden nur gelegentlich mit Finanzdaten zusammengeführt, was konsistente, kontextreiche Erkenntnisse erschwerte.

Die Organisationen benötigten eine Analytics-Fähigkeit, die über Teams und Funktionen hinweg skaliert, bei Bedarf nahezu Echtzeit-Reporting unterstützt und die Abhängigkeit von einem kleinen zentralen Team reduziert. Eine zentrale Anforderung war Self-Serve: Nutzer sollten verlässliche Daten direkt in Power BI analysieren können und – wo sinnvoll – über Excel-Verbindungen auf eine governte semantische Schicht zugreifen.

Vorgehensweise

Wir starteten mit der Definition eines „Single Source of Truth“-Betriebsmodells: konsistente Metrikdefinitionen, gemeinsame Dimensionsstrukturen und klare Ownership für jedes Dataset. Zuerst priorisierten wir die wertvollsten Reporting-Domänen (Audience- und Content-Performance, Subscription- und Retention-Signale, Distribution/Notifications sowie Commercial-/Ad-Performance) und entwarfen anschließend Pipelines, um diese Feeds in einer gemeinsamen Struktur zu konsolidieren.

Angesichts der kleinen Teamgröße (ein Engineer, ein Data Scientist, zwei Analysten) lag der Fokus darauf, manuellen Aufwand zu minimieren und wiederkehrende Engpässe zu beseitigen: standardisierte Ingestion-Patterns, wiederverwendbare Transformationskonventionen, automatisierte Data-Quality-Checks und ein Publishing-Workflow, der es Analysten ermöglicht, neue Datasets und Reports zu liefern, ohne ständig Engineering-Unterstützung zu benötigen.

Dort, wo das Geschäft schnellere Entscheidungszyklen brauchte, führten wir eine pragmatische „Real-Time-wo-es-zählt“-Schicht ein, statt alles konsequent auf Low-Latency auszurichten.

Lösung

Die gelieferte Lösung war ein moderner Analytics-Stack mit einer geschichteten Architektur: Ingestion aus mehreren Quellsystemen, ein zentraler Datenspeicher für kuratierte Datasets und eine governte Data-Mart-Schicht, die explizit für Reporting und Self-Serve-Analysen ausgelegt ist. Transformationen wurden strukturiert und wartbar umgesetzt, sodass sich neue Quellen und neue Reporting-Anforderungen schnell ergänzen lassen, ohne bestehende Outputs zu destabilisieren.

Auf der kuratierten Schicht bauten wir gemeinsame Power-BI-Semantikmodelle und Dataflows auf, um Measures und Dimensionen zu standardisieren und mehreren Reports die Wiederverwendung derselben Logik zu ermöglichen. Dadurch konnten Business-User in Power BI mit konsistenten Definitionen arbeiten und – wenn nötig – über Excel auf dieselbe semantische Schicht zugreifen, um tiefer zu analysieren.

Betrieblich umfasste der Stack Monitoring und Refresh-Orchestrierung sowie Kontrollen, um Reporting stabil zu halten, wenn sich Quellsysteme verändern.

Ergebnis

Die Organisationen wechselten von einer Abhängigkeit von spreadsheet-basiertem Reporting zu einer skalierbaren Reporting- und Analytics-Fähigkeit mit konsistenten Definitionen und wiederverwendbaren Modellen. Teams erhielten eine verlässliche, gemeinsame Sicht auf die Performance, indem mehrere digitale Quellen zu kontextreichen Auswertungen zusammengeführt wurden – dadurch reduzierte sich das Problem „mehrerer Wahrheiten“ und das Vertrauen in Entscheidungen stieg.

Self-Serve wurde praktikabel: Nutzer konnten einen relevanten Anteil ihrer Fragen direkt in Power BI (oder über governte Excel-Verbindungen) beantworten, ohne auf individuelle Extracts warten zu müssen. Das reduzierte Engpässe im zentralen Team und verkürzte die Durchlaufzeit für neue Anforderungen. Wo Near-Real-Time-Transparenz notwendig war, erhielten Stakeholder schnellere operative Signale, ohne die Integrität des Kern-Reportings zu kompromittieren.

In Summe verbesserte die Lösung die Zuverlässigkeit des Reportings, beschleunigte Iterationen und schuf ein Fundament, das mit zusätzlichen Quellen und Use Cases wachsen kann – ohne proportional steigenden manuellen Aufwand.

Lassen Sie uns sprechen

Gemeinsam arbeiten wir an optimalen Lösungen.